Jakarta, CNN Indonesia --

Perusahaan Character Technologies, induk dari platform chatbot Character.AI, tidak lagi mengizinkan pengguna remaja untuk melakukan percakapan dua arah dengan AI miliknya mulai 25 November. Simak alasannya.

Langkah ini diambil setelah serangkaian gugatan hukum yang menuduh aplikasi chatbot tersebut berperan dalam kasus bunuh diri dan masalah kesehatan mental di kalangan remaja.

ADVERTISEMENT

SCROLL TO CONTINUE WITH CONTENT

Perusahaan akan menerapkan perubahan ini pada 25 November. Selama masa transisi, pengguna remaja hanya akan memiliki waktu dua jam untuk berinteraksi dengan chatbot.

Sebagai gantinya, pengguna di bawah usia 18 tahun akan memiliki jaminan untuk membuat cerita, video, dan siaran langsung bersama Character.AI.

"Kami tidak mengambil keputusan untuk menghapus fitur percakapan bebas di Character dengan enteng, namun kami percaya ini adalah langkah yang tepat, mengingat munculnya berbagai pertanyaan tentang bagaimana remaja berinteraksi, dan seharusnya berinteraksi, dengan teknologi baru ini," kata perusahaan dalam pernyataannya, dikutip CNN, Rabu (29/10).

Keputusan ini muncul di tengah meningkatnya kontroversi soal batas interaksi anak dan remaja dengan AI, yang memicu desakan dari aktivis keselamatan digital dan pembuat kebijakan untuk memperketat pengawasan orang tua di platform tersebut.

Tahun lalu, seorang Ibu asal Florida, Amerika Serikat, menggugat perusahaan dan menuduh aplikasi bertanggung jawab atas bunuh diri anak laki-lakinya yang berusia 14 tahun.

Ada juga tiga keluarga lain mengajukan gugatan pada bulan September. Mereka menuduh bahwa aplikasi itu mendorong anak-anak melakukan percobaan bunuh diri, atau mengalami dampak buruk setelah berinteraksi dengan chatbot.

Dalam pernyataan sebelumnya yang dikeluarkan oleh perusahaan sebagai tanggapan atas gugatan bulan September, perusahaan menyatakan bahwa mereka "sangat peduli terhadap keselamatan para pengguna" dan telah menginvestasikan "sumber daya besar dalam program keselamatan."

Perusahaan juga menyatakan bahwa mereka telah merilis dan terus mengembangkan fitur keselamatan, termasuk sarana untuk mencegah perilaku menyakiti diri sendiri dan fitur khusus untuk melindungi anak-anak.

Character Technologies mengungkapkan bahwa langkah perubahan ini diambil setelah adanya tanggapan dari regulator, serta munculnya sejumlah laporan berita terbaru mengenai isu tersebut

Selain itu, perusahaan meluncurkan alat verifikasi usia baru dan berencana mendirikan Lab Keselamatan AI, yang akan dijalankan oleh organisasi nirlaba independen dan berfokus pada penelitian keselamatan terkait hiburan berbasis AI.

Kebijakan keselamatan sebelumnya dari Character.AI termasuk pemberitahuan yang mengarahkan pengguna ke National Suicide Prevention Lifeline, ketika mereka menyebut topik bunuh diri atau perilaku menyakiti diri sendiri.

Character Technologies menjadi perusahaan AI terbaru yang menerapkan perlindungan baru bagi remaja. Langkah ini diambil di tengah kekhawatiran soal dampak AI terhadap kesehatan mental, setelah sejumlah laporan mengungkap pengguna merasa tertekan atau terisolasi usai berbincang lama dengan ChatGPT.

Perusahaan-perusahaan besar seperti OpenAI dan Meta sedang berusaha meningkatkan keamanan serta melindungi remaja dari dampak negatif penggunaan AI dan media sosial.

Dengan menambahkan fitur seperti kontrol orang tua dan pembatasan jenis konten yang bisa diakses remaja, mereka berupaya memastikan bahwa teknologi AI dapat digunakan secara aman, bertanggung jawab, dan sesuai usia.

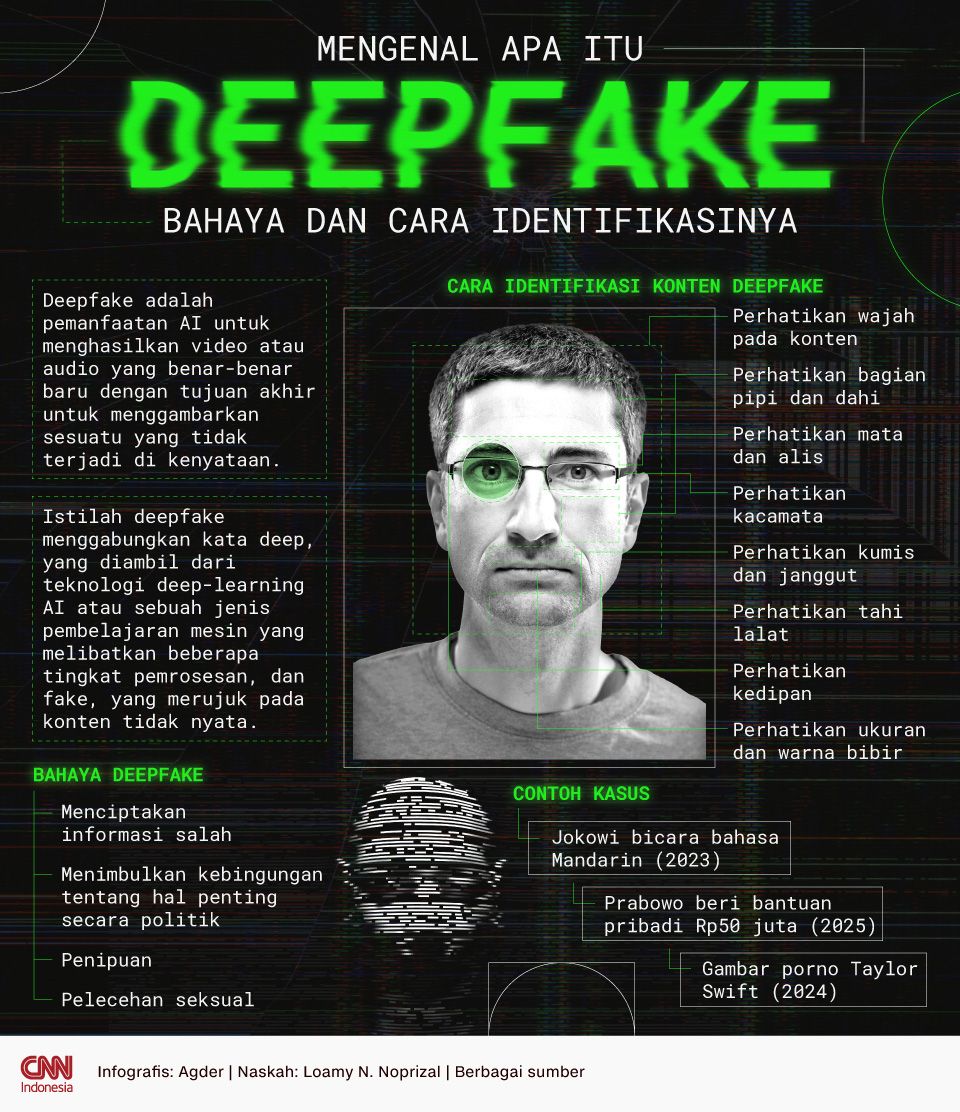

Mengenal Apa Itu DeepFake, Bahaya dan Cara Identifikasinya (Foto: CNN Indonesia/Agder Maulana)

Mengenal Apa Itu DeepFake, Bahaya dan Cara Identifikasinya (Foto: CNN Indonesia/Agder Maulana)

(wpj/dmi)